Auf der Open Source Convention (OSCON) Ende Juli 2011 machte die Cloud in Portland ihre ersten Schritte in Richtung Standardisierung. Die Open Cloud Initiative (OCI) wurde gegründet und ist ein Zeichen, dass das Thema Cloud Computing auch in der Open-Source-Community auf Interesse stößt.

Im Gründerkreis der Initiative findet man einige wichtige Persönlichkeiten. Sie leiten die OCI und bilden ein Direktorium. Der Bekannteste ist wohl Sam Ramji, der ehemalige Open-Source-Chefstratege von Microsoft. Weitere Initiatoren sind:

- Evan Prodromou

- John Mark Walker

- Marc Fleichmann (Chef von Rising Tide Systems)

- Noirin Plunkett (Executive Vice President der Apache Software Foundation)

- Rick Clark (Principal Engineer für Cloud Computing bei Cisco)

- Shanley Kane (Head of developer relations bei Apigee)

- Simon Wardley

- Thomas Uhl (Vorstand der Linux Solutions Group (Lisog) und Gründer der Cloud-Initiative Deutsche Wolke)

Den Posten des Präsidenten hat der Australier Sam Johnston übernommen. Er hat sich schon 2009 mit Standards für die Cloud auseinandergesetzt und veröffentlichte einen „Open Letter to the Community„. Darin skizzierte er seine Gedanken zu einer offenen Cloud und formulierte eine präzisere Definition, was Offenheit im Kontext der Cloud bedeutet. Er kündigte schon damals die Gründung einer Open Cloud Initiative an. Dieses Vorhaben wurde nun erst letzten Monat umgesetzt.

Auf den ersten Blick erscheint eine Symbiose von Cloud Computing und Open Source eher unlogisch. Man könnte meinen, dass das Prinzip vom Open Source nicht zu Cloud Computing passt. Der Grundgedanke von Open Source ist, dass solch eine Software immer komplett mit Quelltext zugänglich ist. Die Quelltexte liegen dem Anwender vor und er kann sie bei Bedarf abändern. Hinter dem Cloud-Computing-Prinzip steckt ein anderer Gedanke. Der Cloud-Nutzer verwendet eine Software als Service. Das bedeutet, dass ihm die Software und die „Rohdaten“ nicht vorliegen. In den meisten Fällen wollen die Anwender eine Cloud-Software lediglich nutzen und nicht im Quellcode rumbasteln.

Demzufolge geht es der OCI nicht darum, die Open-Source-Definition auf die Cloud zu übertragen. Vielmehr will die Initiative die Prinzipien und Anforderungen für ein offenes Cloud-Computing erarbeiten. Die definierten Prinzipien sollen dazu beitragen, dass man Cloud-Produkte an bestimmen Anforderungen messen kann. Außerdem sollen sich Anbieter und Kunden über die Anforderungen an eine Open-Cloud einfacher verständigen können. Salopp gesagt, damit sie die gleiche Sprache sprechen. So können in gemeinsamer Absprache nützliche Produkte und Services entstehen.

Die Open-Cloud-Prinzipien (OCP) hat die OCI auf ihrer Webseite veröffentlicht. Die zwei wesentlichen Forderungen sind:

- Offene Formate (Definition von Nutzer- und Metadaten)

- Offene Schnittstellen (Ansteuerung der Funktionen)

Eine weitere wichtige Forderung ist Interoperabilität der Cloud-Services. Nur so können Kunden inklusive ihrer Daten problemlos zwischen den Anbietern wechseln und sind neutral, was die Technik betrifft.

Um Barrierefreiheit für den Datentransfer zu ermöglichen, sind Standardisierungen und ggf. ein offener Prozess notwendig. Im gleichen Zug wird ein uneingeschränkter Wettbewerb zwischen Cloud-Anbietern möglich.

Was bedeutet denn nun Standard in diesem Zusammenhang? Darauf gibt die OCI auch eine Antwort. Unter offenen Standards ist eine Sammlung von Regelungen zu verstehen, die in allen Details dokumentiert ist. Die Standards sind nur dann offen, wenn sie veröffentlicht und jedem zugänglich sind. Die Offenheit wirkt sich auch auf die Lizenzierung aus. Die Standards sind lizenzfrei und das Copyright erlaubt eine unentgeltliche (Wieder-)Verwendung.

Die Gründung und Verbreitung des Open-Source-Gedanken im Cloud-Bereich soll Öffentlichkeit über offene Cloud-Produkte informieren und die Industrie zur Entwicklung solcher Produkte ermutigen. Für die Zukunft ist auch ein Zertifizierungsprogramm angedacht.

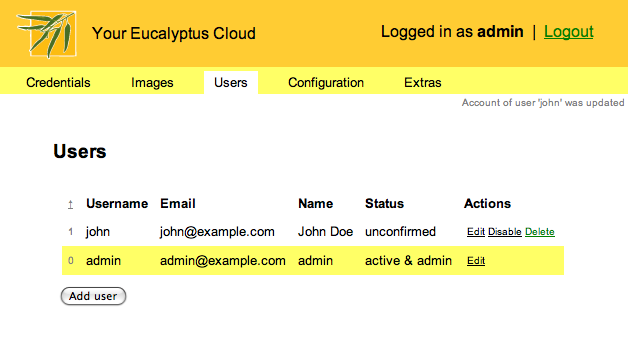

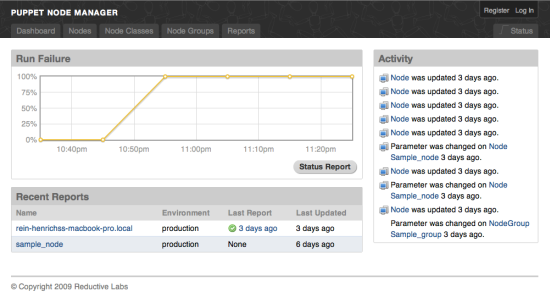

Aktuell sind schon einige Open-Source-Produkte auf dem Cloud-Computing-Markt. Ein paar gute Beispiele werde ich demnächst vorstellen. Es ist abzusehen, dass weitere Firmen auf die „offene Cloud“ aufspringen.